-

chevron_right

chevron_right

LastPass – Un attaque deepfake ratée a ciblé un employé

news.movim.eu / Korben · Friday, 12 April - 09:12 · 1 minute

Les arnaques vocales à base de deep fake comment à se démocratiser. Même les employés des boîtes de sécurité comme LastPass peuvent se faire avoir. Enfin, presque…

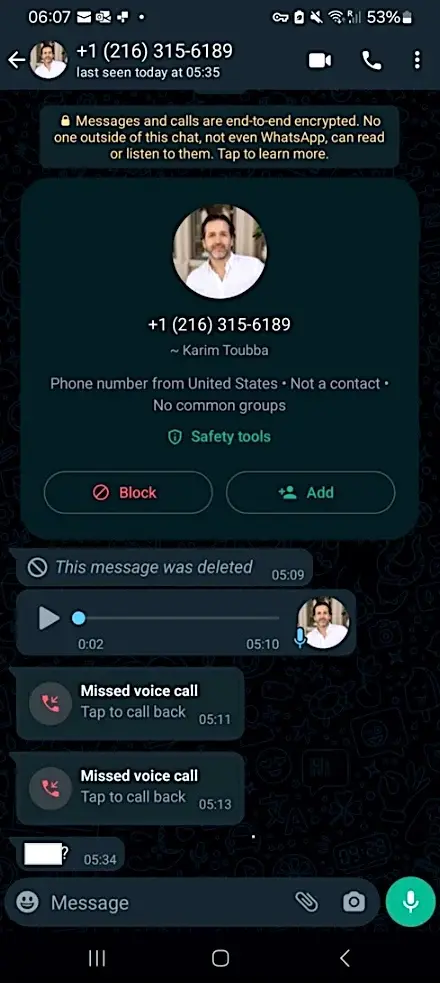

Car oui, récemment, un des leurs s’est fait appeler par un escroc qui imitait à la perfection la voix du big boss, Karim Toubba . Le gars a utilisé un deepfake audio assez sophistiqué pour se faire passer pour le PDG. Mais heureusement, l’employé a flairé l’entourloupe parce que le pirate a fait l’erreur d’utiliser WhatsApp pour son petit numéro de magie, ce qui n’est pas très corporate et bien vu chez Lastpass.

En plus, il mettait la pression avec une fausse urgence. Bref, tous les voyants étaient au rouge.

L’employé a donc envoyé balader l’arnaqueur et a prévenu la sécurité interne, comme ça, pas de dégâts, mais ça montre bien que ces attaques à base d’IA sont de plus en plus sophistiquées. Pour générer la voix du PDG, le pirate a sûrement dû s’entraîner sur des enregistrements publics, comme cette interview du CEO sur YouTube .

En tout cas, si vous recevez un appel de ma part, sachez que ce ne sera pas moi, car la somme d’argent que vous demandera l’escroc ne sera pas assez élevée par rapport à ce que je vous aurais demandé en vrai. Donc méfiance !

Plus sérieusement, le ministère américain de la Santé a tiré la sonnette d’alarme la semaine dernière sur ces arnaques ciblant les services d’assistance IT. Pour se protéger, ils conseillent de :

- Rappeler systématiquement pour vérifier une demande de réinitialisation de mot de passe

- Surveiller les changements suspects de coordonnées bancaires

- Revalider tous les accès aux sites de paiement

- Privilégier les demandes en personne pour les sujets sensibles

- Faire valider les requêtes par un superviseur

- Former les équipes support à repérer l’ingénierie sociale et vérifier l’identité des appelants

Bref, la vigilance est de mise, alors faites tourner !